決定木とは?

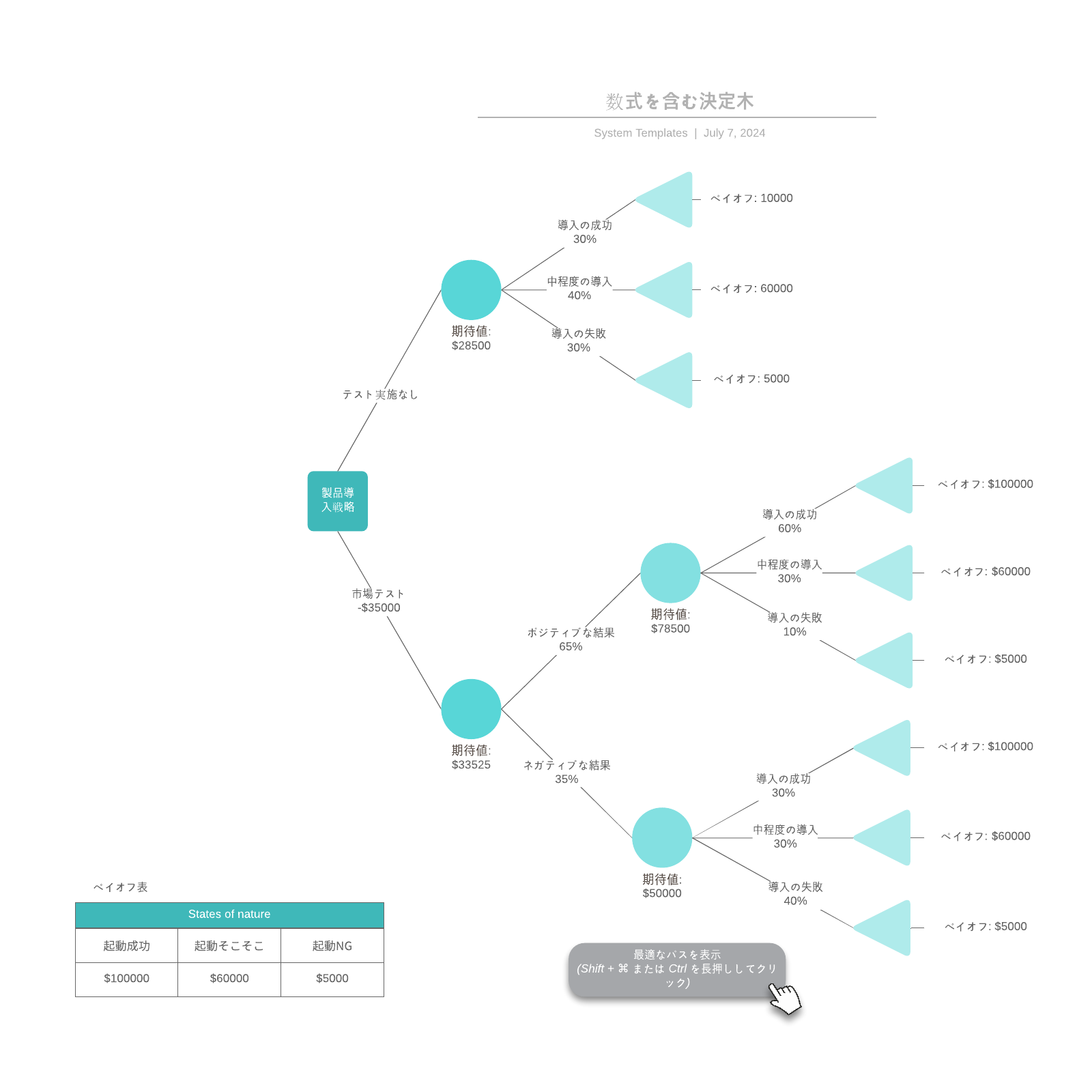

決定木とは、英語で(Decision Tree・ディシジョンツリー・デシジョンツリー)と呼ばれており、一連の関連する選択の想定しうる結果を可視化させた分析です。個人や組織が、コスト、可能性や利点を比較して取りうるアクションを評価する上で有用な図です。非公式な議論を促進したり、数学的に最善の選択を計算するアルゴリズムを図式化したり、さまざまな用途に利用できます。

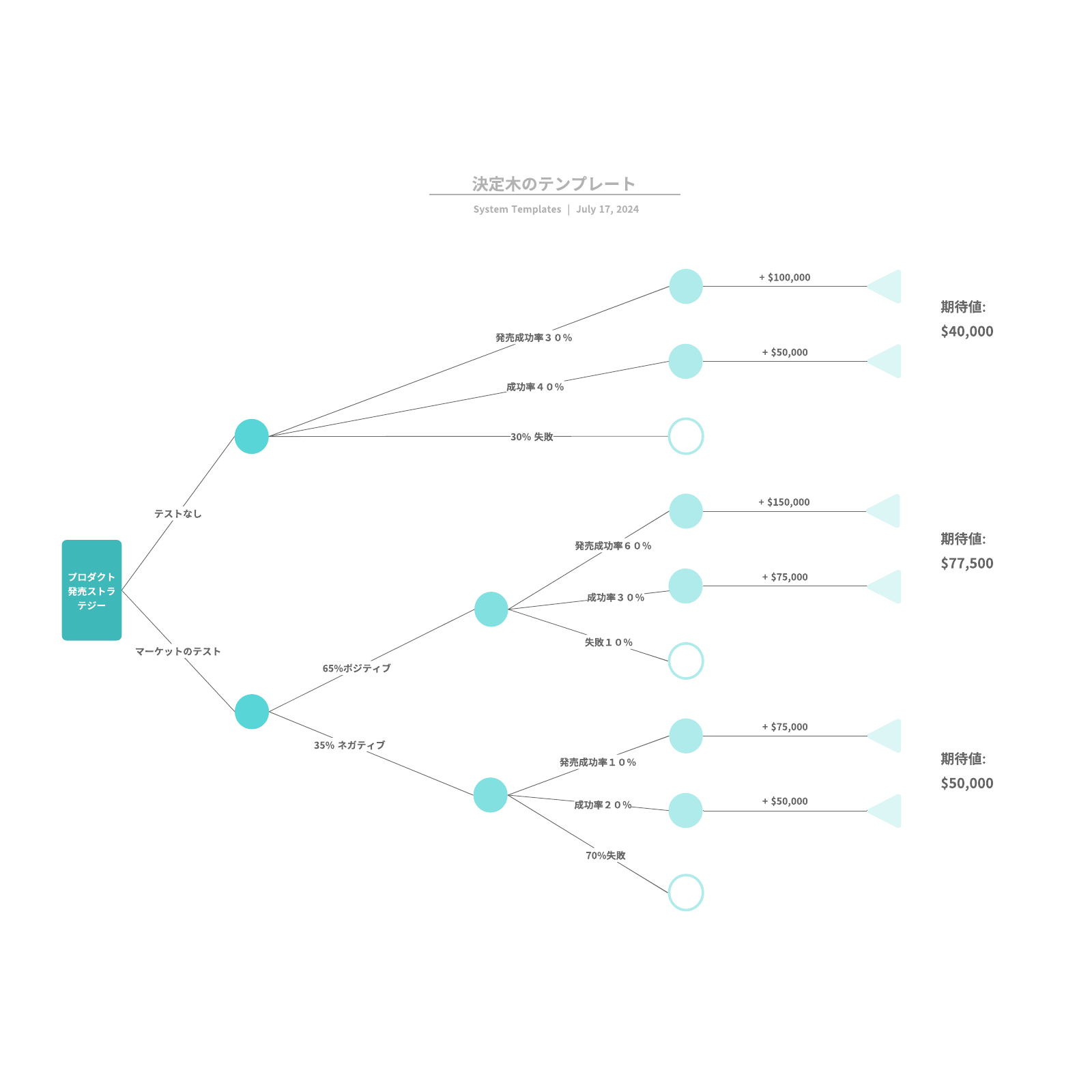

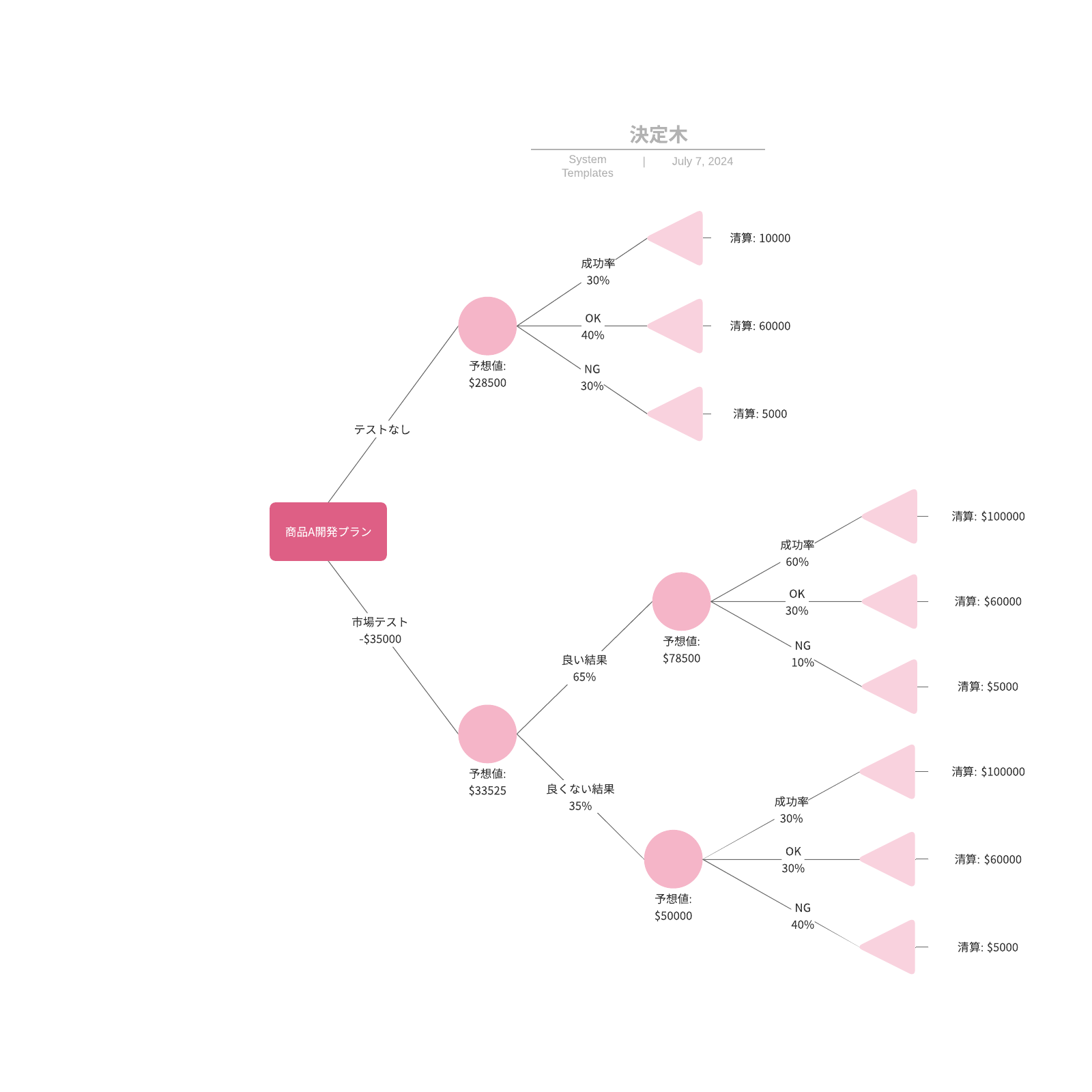

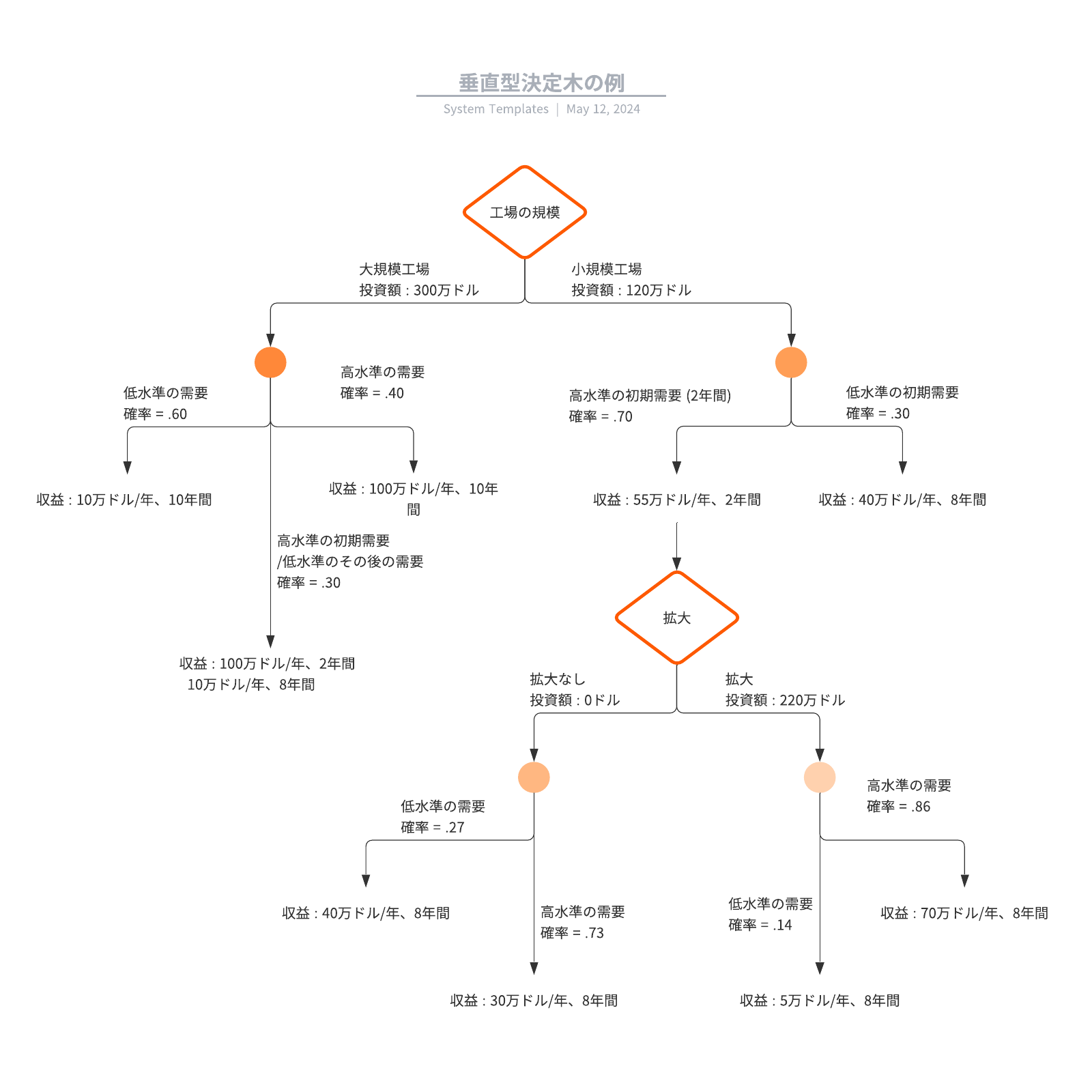

決定木は通常、1つのノードから始まり、想定しうる結果へと分岐していきます。これらの結果はそれぞれ、他の可能性へと分岐する追加のノードへとつながります。結果として、木のような形が形成されます。

ノードには、確率ノード、決定ノードと終了ノードの3種類があります。確率ノードは丸で示され、特定の結果の可能性を表します。正方形で示される決定ノードはすべき決定を表し、終了ノードは決定のパスの最終的な結果を示します。

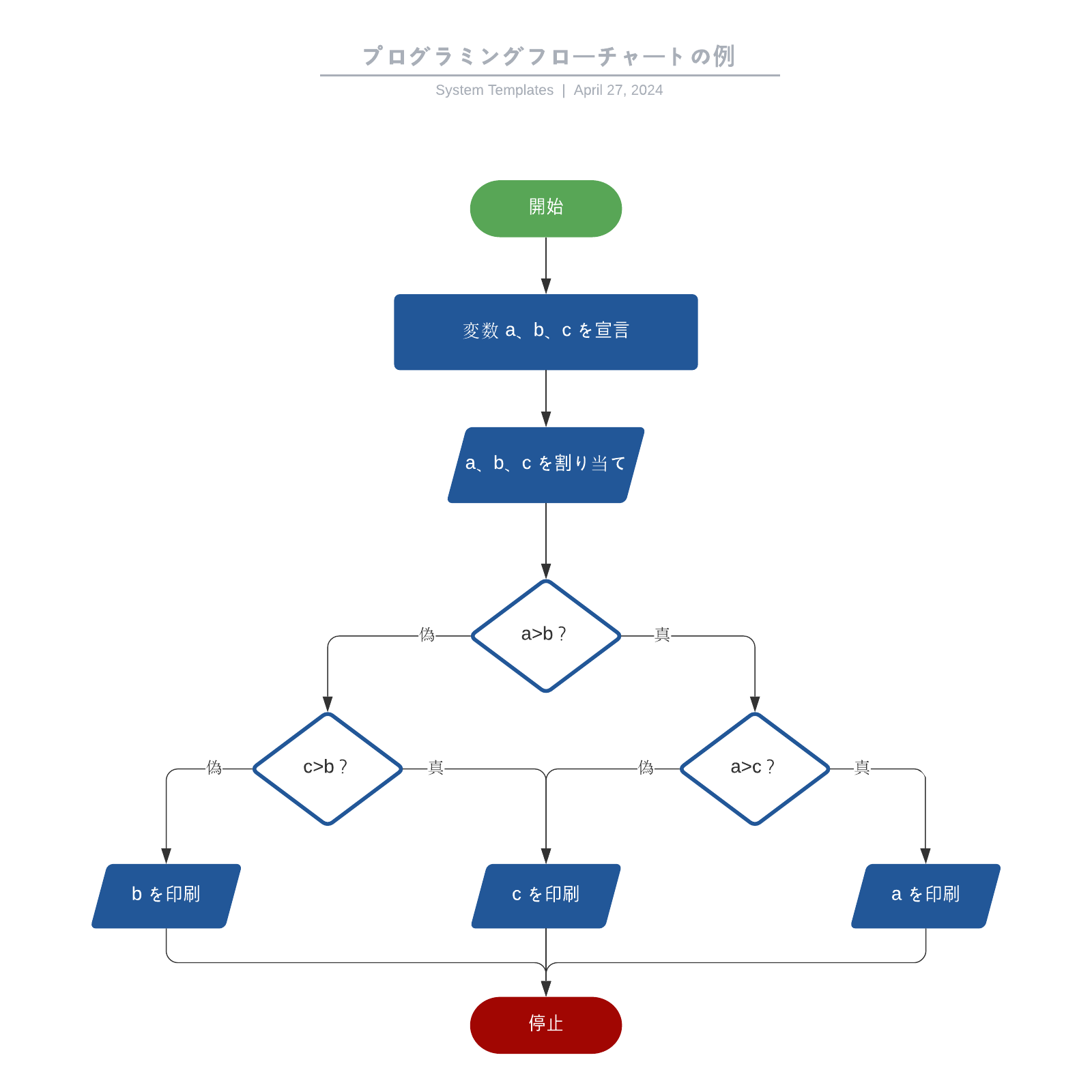

多くの人に馴染みがあり、比較的わかりやすいフローチャート記号で決定木を作成することも可能です。

覚えておきたい決定木の種類

- 分類木 - 分類木は、データセット内の観測値を目的変数の値に分類するためのモデルです。各ノードでデータを分割し、その分割に基づいて目的変数を予測します。

- 回帰木 - 回帰木は、目的変数が連続値である場合に使用される決定木の一種です。回帰木は分類木と同じく、各ノードでデータを分割し、その分割に基づいて目的変数の値を予測します。

- アンサンブル学習 - 複数のモデルを組み合わせて単一の予測モデルを構築する手法です。個々のモデルが弱学習器として知られる場合、そのアンサンブルは強力な予測能力を持つことがあります。

- ランダムフォレスト - アンサンブル学習の一形態であり、複数の決定木を使用して予測を行います。個々の決定木は、データのランダムなサブセットでトレーニングされ、予測結果はそれらの木の平均または多数決に基づいて行われます。ランダムフォレストは、過学習を抑制し、高い予測性能を提供することができます。

決定木の作り方

このセクションでは、決定木分析を正しく可視化させる書き方 を3 ステップでご紹介していきます。

1. 主となる決定から始めます。この点を示す小さなボックスを描画し、ボックスから右側へ線を引いて考えうる解決策やアクションへとつなげます。適宜ラベルを付けます。

2. 確率ノードと決定ノードを追加し、以下のように木を展開していきます。

- 決定がもう1つ必要な場合には、ボックスを追加します。

- 結果が不明確な場合には、丸を描画します (丸は確率ノードを表します)。

- 問題が解決した場合には、(とりあえず) 空白のままとします。

各決定ノードから想定しうる解決策を描き、各確率ノードからは想定しうる結果を示す線を描きます。選択肢を数値的に分析する場合には、各結果の確率と各アクションの費用も含めます。

3. それぞれの線が終点に到達するまで展開を続けます。終点とは、すべき選択や考慮すべき結果がなくなった点を指します。その後、想定しうる結果のそれぞれに値を割り当てます。値としては、抽象的なスコアやまたは金融資産の価値などが考えられます。終点を示す三角形を追加します。

このステップだけで、決定木が完成し、すべき決定について分析する準備が整いました。

決定木分析のメリット

意思決定を迫られる機会は多いものです。企業が誤った意思決定を行うと、財務上の損失、リソースの不適切な使用、企業イメージの悪化など、手痛い失敗を招く可能性があります。ここで役立つのが決定木です。将来を占うことはできませんが、正しい方向へ進むための価値ある洞察が得られる図です。

決定木は以下のように多くのメリットがあります:

- 決定木は理解しやすい

- 感情を交えることなく状況を俯瞰できる

- 具体的なデータの有無にかかわらず利用でき、データの準備が最小限で済む

- 既存の木(ツリー)に新しいオプションを追加できる

- いくつかの選択肢から最善のものが選べる

- 他の意志決定支援ツールと組み合わせやすい

メリットが多いため、決定木は戦略立案、調査内容の分析や結論の導出を目的としてビジネスの現場でよく使われます。融資者や銀行は、融資や投資機会のリスク算定のために決定木を使用しています。インフォグラフィックにもしばしば使われ、雑誌に掲載されたり、SNSで共有される例も数多くあり、あらゆる問いや懸念事項の検討と想定しうる結果の視覚化に応用できる図が決定木です。

決定木・ディシジョンツリーの記号一覧

| 図形 | 名称 | 意味 |

|---|---|---|

| 決定ノード | 行うべき決定を示します。 |

| 確率ノード | 複数の不確実な結果を示します。 |

| 代替分岐 | 分岐はそれぞれ想定しうる結果やアクションを示します。 |

| 拒否された代替 | 選択されなかった選択肢を示します。 |

| 終点ノード | 最終的な結果を示します。 |

Lucidchart の基本を3分でマスター

- テンプレートまたは空白のキャンバスから最初のオンライン決定木を作成するか、文書をインポートします。

- 図形を追加し、線を接続して、文字を書きこみます。

- 決定木のスタイルと書式設定を調整する方法を学びます。

- 「機能を検索」で必要な機能を見つけます。

- 作成した決定木をチーム内で共有し、コラボレーションを開始します。

決定木の活用場面

決定木の欠点や注意点

決定木は便利なツールですが、いくつかの欠点や注意点があります。

決定木は直感的で視覚的に理解しやすい反面、大量のデータや複雑な意思決定に対しては、ツリーの構造が非常に複雑になることがあります。こうした場合、決定木の可読性が低下し、解釈が難しくなることがあります。特に、多数の分岐や深い階層を持つ決定木は、視覚的な混乱を招く可能性があります。

時には決定木分析が複雑になりすぎることもあります。こうした場合は、よりコンパクトな影響図の方が適しているでしょう。影響図は、重要な決定、入力と目標に焦点を絞ったもので、複雑な問題をシンプルに表現するのに役立ちます。

これらの欠点や注意点を考慮することで、決定木を効果的に活用し、より正確な意思決定を行うことができます。

機械学習やデータ分析にも使える決定木

機械学習、データマイニングや統計などに応用する自動予測モデルの構築に決定木を役立てることもできます。決定木学習と呼ばれるもので、ある項目に関する観察を考慮してその項目の値の予測を行う方法です。

これらの決定木では、ノードは決定ではなく、データを表します。分類ツリーとも呼ばれる種類のもので、各分岐には一連の属性または分類ルールが含まれます。これらは、その線の終端に配置される特定の分類ラベルと関連付けられます。

これらのルールは決定ルールとも呼ばれ、「条件1、条件2および条件3が満たされた場合、 y の確率で結果が x となる」というように、各決定またはデータの値で構成される if-then 節で表現することができます。

データを追加することで、値の有限集合のうちどれに対象物が属するかをモデルがより正確に予測できるようになります。その後、この情報をより大規模な意思決定モデルへの入力として利用することができます。

予測変数は、価格などの実数となることもあります。継続的で無限の想定しうる結果を用いた決定木は、回帰木と呼ばれます。

精度を高めるため、以下の方法で複数の木を組み合わせて使うこともあります。

- バギング - ソースデータをリサンプリングして複数の木を作成し、その後これらの木に投票をさせてコンセンサスを導出します。

- ランダムフォレスト分類器 - 分類率を高めるため、複数の木で構成されます。

- ブーステッドツリー - 回帰木と分類木に使用できます。

- ローテーションフォレスト - これに含まれる木はすべて、ランダムなデータの一部への PCA (主成分分析) を使って処理されています。

レベルや質問の数が最小限で、最大限のデータを表示できている図の状態が、決定木として最適なものとされています。最適化された決定木作成のためのアルゴリズムには、CART、ASSISTANT、CLS や ID3/4/5などがあります。ターゲット変数を右側に配置し、相関ルールを構築する方法で決定木を作成することもできます。

いずれの方法でも、各レベルでデータを分割する最善の方法を判断する必要があります。判断の方法としては、ジニ不純度、情報ゲインや分散減少を測定するものが一般的です。

機械学習への決定木の応用には以下の利点があります。

- データ予測への木の使用コストがデータポイントの追加ごとに低減する

- カテゴリーデータと数値データ双方について使用できる

- 複数の出力をもつ問題のモデル化ができる

- ホワイトボックスモデルを使用することで結果が説明しやすくなる

- 木の信頼性をテストおよび定量化できる

- ソースデータの前提条件違反の有無にかかわらず精度が保たれる傾向にある

その反面で、以下のような欠点もあります。

- 複数のレベルを含むカテゴリーデータに応用する場合に、情報ゲインはレベル数の最も多い属性に対して有利となる

- 不確実性やリンクされた結果が多い場合の計算が複雑となる可能性がある

- 決定グラフでは OR によるノード接続が可能であるのに対し、ノード間の接続が AND に限定される